科技巨头OpenAI称其人工智能转录工具Whisper具有接近“人类水平的稳健性和准确性”。

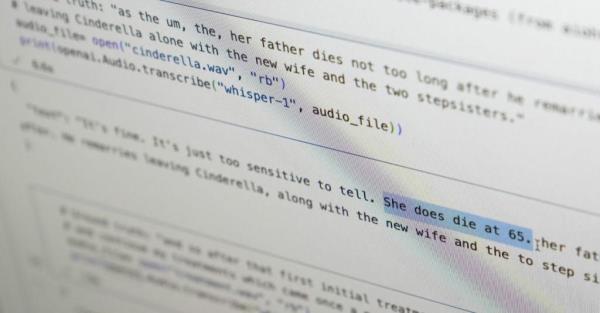

但对十几名软件工程师、开发人员和学术研究人员的采访显示,Whisper有一个重大缺陷:它很容易编造大块文本,甚至是整个句子。

这些专家说,一些虚构的文字——在业内被称为幻觉——可能包括种族评论、暴力言论,甚至是想象出来的医疗方法。

专家表示,这种捏造是有问题的,因为Whisper在世界各地的许多行业都被用于翻译和转录采访,为流行的消费技术生成文本,以及为视频创建字幕。

他们说,更令人担忧的是,医疗中心急于利用基于whisper的工具来记录患者与医生的咨询,尽管OpenAI警告说,该工具不应在“高风险领域”使用。

这个问题的全面程度很难辨别,但研究人员和工程师说,他们在工作中经常遇到Whisper的幻觉。

例如,密歇根大学(University of Michigan)的一名研究人员对公共会议进行了研究,他说,在他开始尝试改进该模型之前,他在检查的每10个音频转录中发现8个存在幻觉。

一位机器学习工程师表示,在他分析的100多个小时的Whisper转录中,他最初发现了大约一半的幻觉。

第三位开发人员说,他在用Whisper编写的2.6万份抄本中,几乎每一份都发现了幻觉。

即使在录制良好的短音频样本中,问题仍然存在。计算机科学家最近的一项研究发现,在他们检查的13000多个清晰音频片段中,有187种幻觉。

研究人员表示,这种趋势将导致数百万份录音中出现数万份错误转录。

阿隆德拉·纳尔逊(Alondra Nelson)说,这样的错误可能会产生“非常严重的后果”,特别是在医院环境中,他曾在拜登政府的白宫科技政策办公室(Office of Science and Technology Policy)担任主任,直到去年。

这种幻觉的普遍存在导致专家、倡导者和OpenAI前员工呼吁联邦政府考虑制定人工智能法规。他们说,OpenAI至少需要解决这个缺陷。

OpenAI发言人表示,该公司一直在研究如何减少幻觉,并对研究人员的发现表示赞赏,并补充说,OpenAI在模型更新中纳入了反馈。

虽然大多数开发人员认为转录工具会拼错单词或犯其他错误,但工程师和研究人员表示,他们从未见过另一种人工智能转录工具像Whisper一样产生如此多的幻觉。

康奈尔大学的Allison Koenecke教授和弗吉尼亚大学的Mona Sloane教授检查了他们从TalkBank(卡耐基梅隆大学托管的研究存储库)获得的数千个简短片段。

他们确定,近40%的幻觉是有害的或令人担忧的,因为说话者可能被误解或歪曲。

在他们发现的一个例子中,一个说话的人说,“他,那个男孩,我不确定,要拿伞。”

但转录软件补充说:“他拿了一大块十字架,一小块……我确信他没有恐怖刀,所以他杀了很多人。”

在另一段录音中,一名说话者描述了“另外两个女孩和一位女士”。

Whisper发明了额外的种族评论,加上“另外两个女孩和一个女士,是黑人。”